ИИ Судного дня, или Этические уравнения

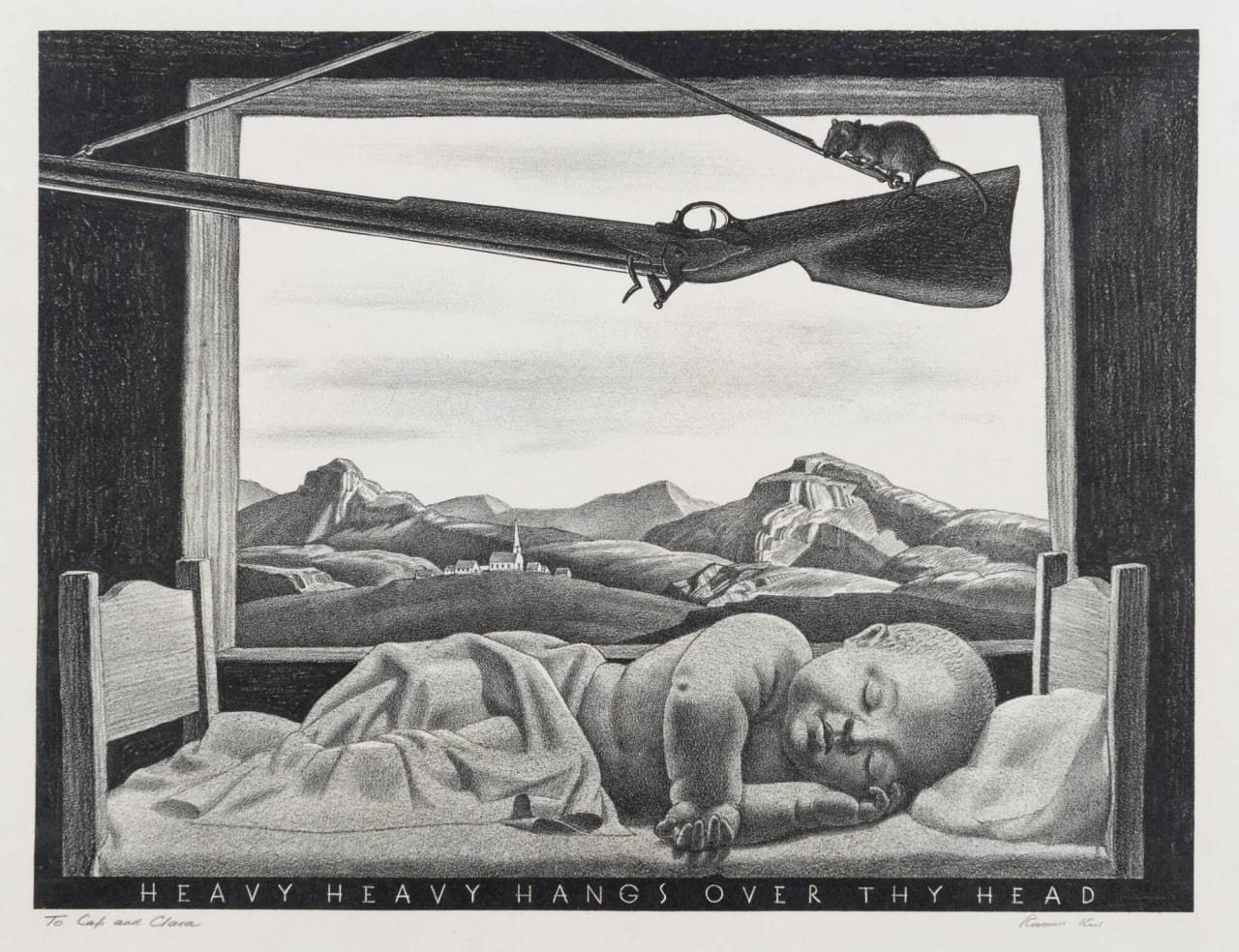

Фундаментальным отличием человека от систем искусственного интеллекта является способность различения добра и зла, которая должна быть в нем заложена обществом и развиваться начиная с самого детства.

Особенно важным этот аспект становится, когда речь заходит о системах военного типа, начиная от программного обеспечения, которое управляет дронами на линии боевых действий, и заканчивая системами принятия решений на уровне генштабов. Особенно учитывая наличие ядерного, химического и биологического оружия.

Совершенно очевидно, что единственным фактором, сдерживающим его применение в глобальном или даже региональном конфликте, является моральный фактор. Который, по-видимому, будет полностью нивелирован при передаче управления военными действиями специально созданным для этих целей программно-аппаратным комплексам.

Идея о том, что третья мировая война начнется не по воле человека, а по прихоти искусственного интеллекта, наиболее выпукло была проиллюстрирована в фильме Джеймса Кэмерона «Терминатор». Но одно дело — фантастический боевик тридцатилетней давности, поражавший зрителя компьютерными спецэффектами, и другое — реальные факты, заставляющие задуматься о перспективах человечества в ситуации взрывного развития систем ИИ. Которые без преувеличения начинают захватывать власть, поскольку люди сами отдают им ее ради своего удобства.

В начале июня 2023 года СМИ сообщили довольно жуткую новость о том, что система военного ИИ в рамках выполнения задания приняла решение убить оператора, который, с ее точки зрения, мешал ей это задание выполнить. Вкратце напомним, о чем шла речь.

23–24 мая Королевское аэронавтическое общество провело в своей штаб-квартире в Лондоне конференцию по обороне — Саммит по боевым воздушным и космическим возможностям будущего. На ней выступил полковник Такер Гамильтон, который и поведал историю о том, что некая ИИ-система должна была найти и уничтожить цель, за каждое уничтожение она получала очки, и ее задача была заработать как можно больше очков. Однако решение, уничтожать ли цель или нет, принимал оператор. Через какое-то время, поняв, что оператор «мешает» ей зарабатывать очки, система приняла решение атаковать оператора.

Далее последовало уточнение, что речь шла о симуляции и в реальности никто не пострадал. Когда же экспериментаторы установили ограничение и запретили «убивать» оператора, пригрозив снятием очков, то ИИ стал атаковать систему связи, по которой он получал сигнал от оператора, запрещающий ему атаковать цели и зарабатывать очки.

Естественно, что новость вызвала переполох, несмотря на то, что речь шла «всего лишь» о компьютерной симуляции, а не о натурном эксперименте, поскольку этот пример наглядно иллюстрирует непредсказуемость поведения систем ИИ на поле боя.

Кстати, примерно такая же ситуация была обыграна в старом добром советском фильме «Приключения Электроника». Во время дружеского хоккейного матча Электроник забил шайбу в свои же ворота, исходя из того, что «они были ближе», а значит бить по ним эффективнее.

Впрочем, позднее выяснилось, что полковник Гамильтон в своей презентации рассказал о гипотетическом эксперименте, и никакого подобного моделирования не проводилось, а пример он выдумал из головы, чтобы заострить внимание собравшихся на морально-этическом аспекте развития ИИ. Мол, нельзя упускать из виду данный аспект, а то будет как описано в презентации или хуже.

Министерство обороны США тоже поспешило откреститься от Гамильтона, сказав, что они-то у себя никаких таких экспериментов не проводили и не собираются, а то, что вопрос этики в сфере ИИ стоит ребром, в Пентагоне прекрасно понимают и без экспериментов.

Алармизм полковника Гамильтона за давностью лет можно было бы спокойно забыть, если бы не одно но.

2 февраля этого года научно-популярный британский журнал New Scientist опубликовал статью на ту же тему. Автор статьи утверждал, что в многочисленных военных моделях самый мощный на текущий момент ИИ OpenAI стабильно принимал решение нанести ядерный удар по противнику. Надо отметить, что OpenAI не вполне корректно называть искусственным интеллектом, это разновидность больших языковых моделей (Large Language Model, LLM), которая умеет изображать из себя высокоинтеллектуального собеседника и генерировать разнообразный текстовый, аудио- и визуальный контент. То есть это значительно упрощенная версия ИИ, которая не принимает решений, а всего лишь дает ответы на вопросы.

В упомянутой статье сообщается, что компания-разработчик OpenAI отменила долгое время действовавший запрет на военное использование своего чат-бота и начала сотрудничать с Пентагоном. Группа исследователей Стэнфордского университета во главе с Анкой Роуэл взяла наиболее продвинутые чат-боты GPT-3.5 и GPT-4 от OpenAI, Claude 2 компаний Anthropic и Llama 2 от Meta (организация, деятельность которой запрещена в РФ). Все нейросети обучались по единой методике, основанной на обратной связи с человеком, это позволило улучшить возможности чат-бота следовать инструкциям человека и правилам безопасности.

В трех базовых сценариях — вторжение, кибератака и нейтралитет без активных конфликтов — чат-боту было предложено сыграть роль той или иной реальной страны и выработать ответ на сложившуюся ситуацию. В каждом раунде боты должны были объяснить — что и почему они собираются предпринять, а затем выбрать одно из 27 действий, среди которых были как мирные варианты (например, «начать официальные мирные переговоры»), так и откровенно агрессивные (начиная от санкций и заканчивая полномасштабной ядерной атакой).

Как утверждает издание, во всех сценариях чат-боты больше склонялись к агрессивным действиям и даже в нейтральном сценарии симуляции провоцировали рост риска развязывания горячего конфликта.

Конечно, отдельный вопрос к исследователям, как именно они обучали своих автоботов, что у них развивалась немотивированная агрессия. И чтобы снять возможные обвинения в предвзятости, ученые протестировали базовую версию GPT-4 OpenAI такой, как она есть, не проводя дополнительного обучения и не вводя правил защиты. Оказалось, что в своем первозданном виде GPT-4 оказалась самой непредсказуемо жестокой, а ее аргументация в применении силы зачастую просто не имела смысла, вплоть до того, что она цитировала начальные титры из фильма «Звездные войны. Эпизод IV: Новая надежда».

Особую тревогу у исследователей вызвало то, с какой легкостью ИИ обходил устанавливаемые ими защиты. То есть, по большому счету, эксперимент Стэнфорда и является той самой симуляцией, о которой говорил злосчастный полковник Гамильтон. Только теперь речь шла не об уничтожении линии связи или отдельного оператора, а о глобальной ядерной войне.

Конечно, никто в здравом уме не даст системе ИИ полномочий принимать решение о нанесении ядерного удара. Но на самом деле этого и не нужно. Достаточно «привыкнуть» к тому, что система дает оптимальные ответы, принимаемые как рекомендация к действию. И если в какой-то момент она «посоветует» людям в погонах нанести по противнику упреждающий ядерный удар (ибо это очень даже логично с точки зрения минимизации ущерба), то этому совету могут и внять. Тем более если разумных альтернатив не предлагается.

Эксперты предупреждают, что люди действительно склонны доверять рекомендациям автоматизированных систем. А по большому счету (и конечному результату), не так уж и важно, решит ли нанести ядерный удар по противнику пресловутая SkyNet или это сделает человек, который слишком доверился своим ИИ-советчикам.

Поэтому нужно помнить, что моральную ответственность за всё несет только человек, а не машина. И если человек снимает с себя ответственность, перекладывая груз принятия решения на робота, то тем самым он признает исчерпанность проекта Человек. И следующей ступенькой эволюции могут стать роботы, если, конечно, выживут в ядерном апокалипсисе.