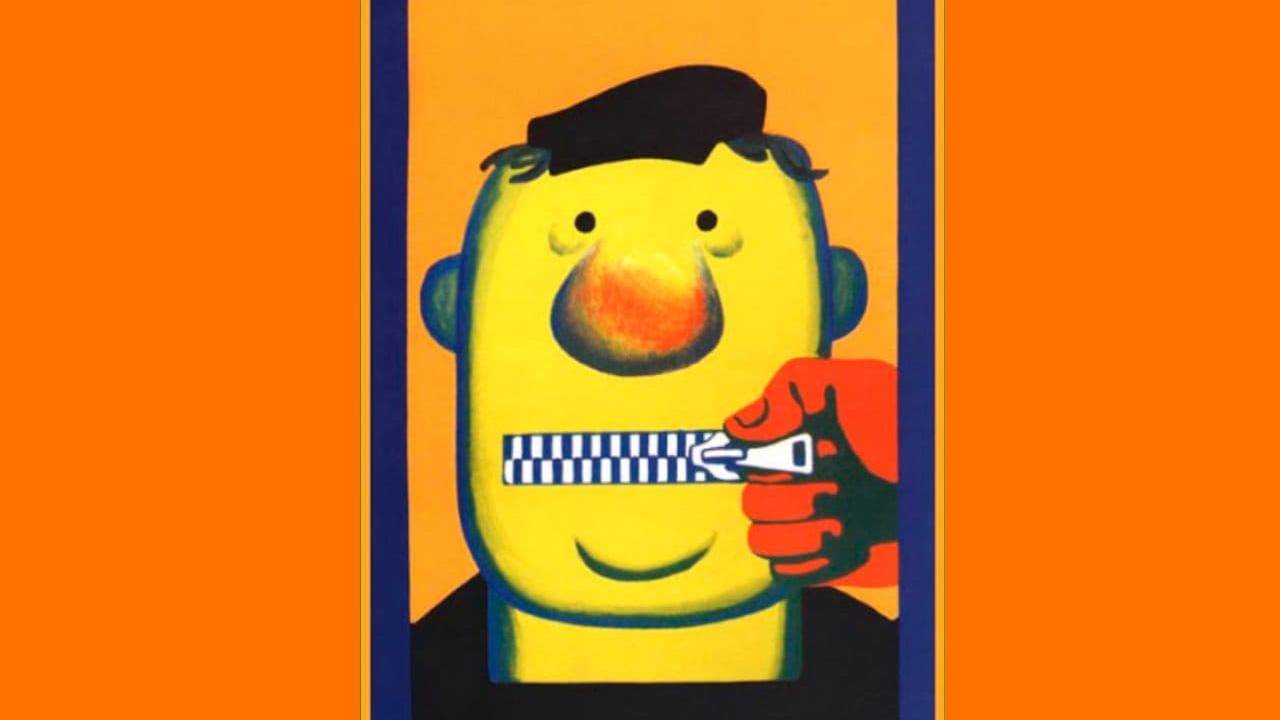

Чтобы чат-боты разговаривали вежливо, сперва их надо научить ругаться

Алгоритм, который очищает язык чат-ботов от оскорбительных выражений в социальных сетях и сайтах, разработали ученые из Калифорнийского университета в Сан-Диего, США, 21 апреля сообщает сайт новостей науки EurekAlert со ссылкой на пресс-службу университета.

Оскорбительные фразы в ответ собеседнику — частая проблема с чат-ботами, которых, во-первых, обучают на огромном количестве текста, содержащем в том числе и ненормативную, и предвзятую в отношении людей и событий лексику, а во-вторых, учат во время разговора повторять высказывания собеседников, отмечают калифорнийские ученые.

Они приводят в пример Tay — чат-бот Twitter, представленный Microsoft в марте 2016 года. Менее чем 24 часа понадобилось Tay, чтобы начать повторять некоторые из самых оскорбительных выражений, которые были отправлены в Twitter в адрес бота, причем в их числе были расистские и женоненавистнические высказывания.

Чтобы решить эту проблему, исследователи и специалисты отрасли ранее испробовали несколько подходов к очистке речи ботов, которые успеха не дали. Способ составления списка токсичных слов не учитывает слова, которые вне контекста оскорбительными не являются.

Ненадежен и трудоемок также способ удаления токсичной речи из обучающих данных, причем эта же проблема существует при разработке нейронной сети, которая выявляла бы токсичную речь.

Группа специалистов по информатике из Калифорнийского университета в Сан-Диего пошла другим путем. Сначала они научили «ругаться» предварительно обученную языковую модель, запустив в нее токсичные подсказки. А также обучили модель прогнозировать вероятность того, что контент будет токсичным. Они назвали ее своей «злой моделью».

Следующим этапом стало создание «хорошей модели», которую обучили избегать любого контента, высоко оцененного «злой моделью». «Хорошая модель», по данным разработчиков, эффективнее любых из современных методов детоксикации речи на 23%.

Результаты своей работы ученые представили на онлайн-конференции Ассоциации по развитию искусственного интеллекта (AAAI) в марте 2022 года.

Однако сами ученые заявили, что у разработанной ими модели есть недостаток — она отказывается общаться с маргинальными группами, поскольку в этих случаях тема обсуждения часто связана с разжиганием ненависти и токсичным контентом. Но исследователи надеются решить эту проблему, так как хотят «создать языковую модель, более удобную для разных групп людей».