Разработан ИИ, который решает, нужен для диагностирования врач или нет

Новая модель искусственного интеллекта (ИИ), работающая в сфере диагностики заболеваний, позволяет определить сложные случаи, по которым требуется консультация живого специалиста, заявили разработчики из Лаборатории компьютерных наук и искусственного интеллекта (CSAIL) Массачусетского технологического института (MIT), 3 августа сообщает новостной портал «Хайтек».

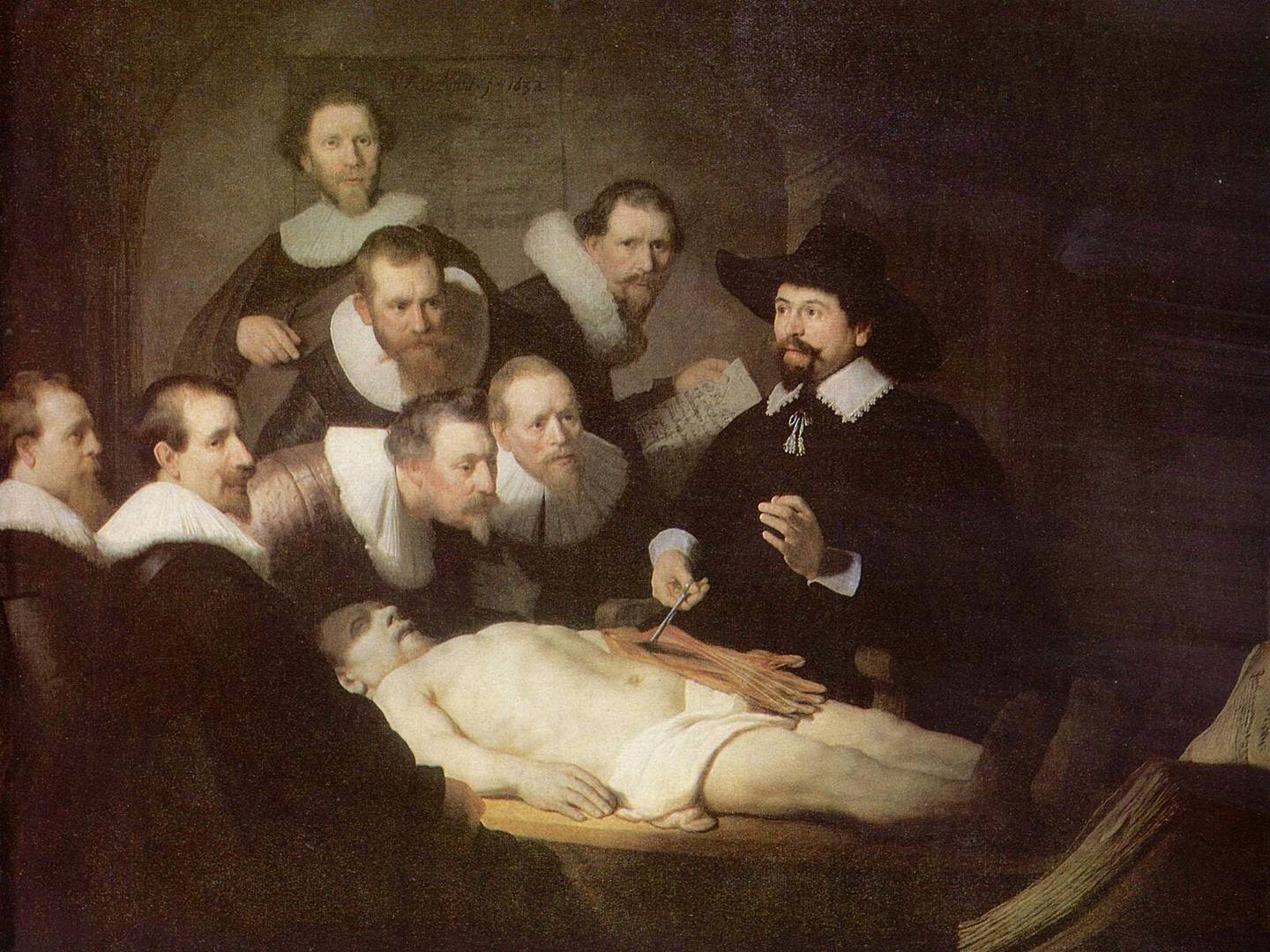

Разработанная система диагностики заболеваний может диагностировать у пациента рак легких, груди, мозга, кожи и шейки матки. Несмотря на значительные успехи в диагностировании, разработчики столкнулись с проблемой, что в ряде случаев их система выдает значительно менее точные результаты, чем живой специалист.

Для решения этой проблемы они добавили в систему дополнительный модуль, основанный на машинном обучении, который может определить, способна система самостоятельно справиться с диагностикой конкретного случая или нужно обратиться к специалисту. Причем, принимая решение о перенаправлении рассматриваемого случая специалисту, она выбирает человека, который наиболее компетентен в этом вопросе. Выбор специалиста осуществляется не только с учетом уровня компетенции, но и его загруженности другими задачами.

Команда разработчиков признается, что разработанные модели пока не получается целиком внедрить в условиях реальной больницы. Частично эта проблема связана с недоверием врачей. С помощью добавления дополнительного звена принятия решений они пытались сделать модель более безопасной и тем самым снизить степень недоверия к ней. Также они предлагают протестировать разработанную систему в сотрудничестве с несколькими группами рентгенологов, которые специализируются на разных группах пациентов и имеют большой опыт работы.

Многие социологи рассматривают социальные последствия внедрения систем искусственного интеллекта в повседневную жизнь. В частности, для понимания роли ИИ в жизни человека стоит задаться вопросом: кто принимает окончательное решение?

ИИ, встроенные в GPS-навигаторы для прокладывания дороги, только предлагают на выбор несколько маршрутов, но куда ехать — решает человек. Это самое безопасное использование ИИ. Хотя и в таком случае есть проблема, связанная с тем, способен ли человек проверить расчеты компьютера или он может принимать их только на веру.

Второй этап развития ИИ, с социальной точки зрения, подразумевает делегирование права на принятие решения. Игровой ИИ может не только просчитать ходы, но и решить, какой из вариантов стратегии он будет использовать. Когда от правильности принятия решения зависят человеческие жизни — это всегда будет вызывать подозрения. На этом этапе человек становится в прямой зависимости от ИИ, так как именно ИИ решает, что для человека лучше. Второй этап подразумевает принятие решений, которые могут быть сопряжены с существенными рисками для жизни, но направлены принципиально на благо человека.

Рассматриваемая в новости технология находится именно на этом этапе. Поэтому врачи, осознавая потенциальную опасность, сопротивляются внедрению такой технологии в эксплуатацию. Плюс, существует немаловажный вопрос юридической ответственности за принятое решение.

В отличие от второго этапа, на третьем этапе будут приниматься решения, кому жить, а кому умереть. В качестве примера таких систем можно привести военные дроны, используемые для выявления и ликвидации, например, террористов. Другим подобным примером может быть робот-судья, принимающий решения о степени уголовной ответственности обвиняемого.

На сегодняшнем этапе вопрос о степени доверия системам ИИ стоит перед человечеством очень остро. Чтобы не допустить фатальных ошибок, нужно уже сейчас задуматься над созданием международных механизмов контроля за разработкой систем ИИ.

(теги пока скрыты для внешних читателей)