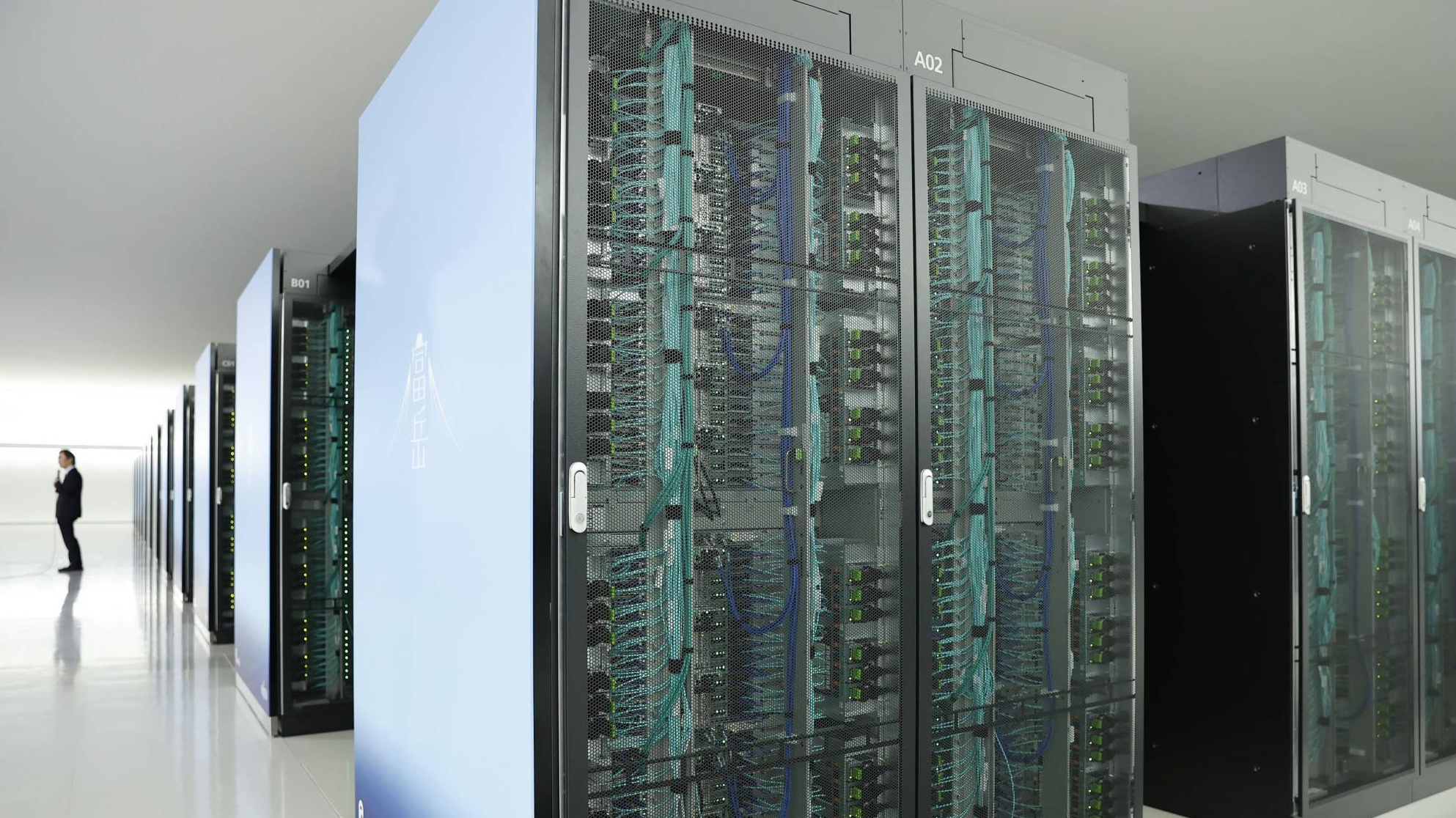

Tesla представила спецпроцессор D1, «заточенный» под машинное обучение

Новый процессор D1, специализирующийся на задачах машинного обучения, представила компания Tesla, 20 августа сообщает портал VideoCardz.

Чип изготавливается по 7-нм техпроцессу и включает 50 млрд транзисторов на кристалле площадью 645 кв. мм. По площади кристалла он уступает графическим процессорам Nvidia A100 (826 кв. мм) и AMD Arcturus (750 кв. мм).

При этом в процессоре D1 имеется 354 обучающих узла на основе четырехядерных 64-разрядных суперскалярных процессоров, которые оптимизированы для эффективного умножения 8×8 и поддерживают широкий спектр инструкций, используемых для обучения ИИ, в том числе FP32, BFP16, CFP8, INT32, INT16 и INT8.

Согласно оценкам Testa, производительность D1 составляет 22,6 TFLOPS на вычислениях с одинарной точностью на данных FP32 и до 362 TFLOPS на данных BF16/CFP8. При этом параметр TDP составляет 400 Вт.

Для обеспечения масштабируемости Tesla создала внешний интерфейс с пропускной способностью до 10 ТБ/с, посредством которого процессоры D1 могут объединяться в группы («плитки») по 25 штук, а те в свою очередь можно объединять в более крупные блоки.

Одну из таких «плиток» из 25 процессоров D1 компания продемонстрировала работающей в лабораторных условиях на частоте 2 ГГц с производительностью 9 PFLOPS.

Кроме того, Tesla заявила о планах создания полноценного суперкомпьютера на чипах D1 — ExaPOD, который будет состоять из 120 «плиток» (3 тыс. чипов D1) при этом расчетная производительность на операциях FP16/CFP8 составит, по оценке компании, 1.1 ExaFLOPS.

Это сделает данный суперкомпьютер самым быстрым для машинного обучения, превосходящим нынешние суперкомпьютеры Tesla на базе чипов NVIDIA в 4 раза по производительности, в 1,3 раза по производительности на ватт и в 5 раз компактнее по площади.