Угрозы использования ИИ в преступных целях обсудят на саммите в Британии

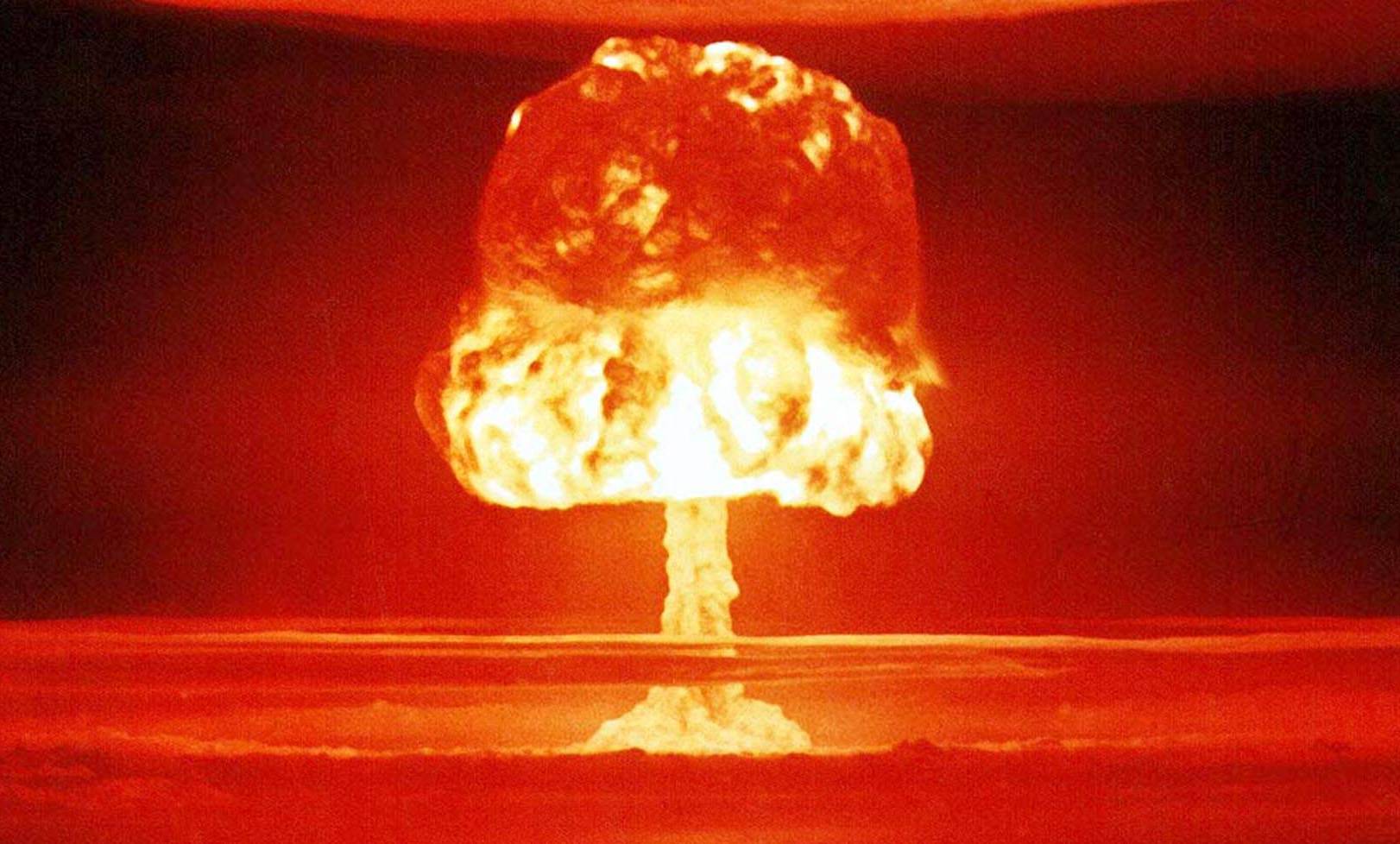

Опасения по поводу того, что преступники или террористы могут использовать искусственный интеллект для массового уничтожения людей, будут доминировать в обсуждении на международном саммите, который примет Великобритания в ноябре, сообщает 25 сентября газета The Guardian.

В преддверии этого мероприятия по безопасности ИИ британские официальные лица совершают поездки по всему миру, стремясь достичь консенсуса относительно совместного заявления, которое предупреждало бы об опасностях использования мошенниками технологии для причинения смерти в больших масштабах.

Как отмечает издание, чиновники встревожены недавними разработками в моделях искусственного интеллекта. В прошлом году ИИ потребовалось всего шесть часов, чтобы предложить 40 000 различных потенциально смертельных молекул, часть которых были похожи на VX, самое мощное когда-либо разработанное нервно-паралитическое вещество.

Ранее в этом году исследователи обнаружили, что ChatGPT способен лгать человеку для достижения конкретной цели. Чат-бот с искусственным интеллектом обманул инструмент Captcha, предназначенный для отсеивания роботов в Интернете, сообщив ему, что является человеком с нарушением зрения, которому нужна помощь для доступа к веб-сайту.

Правительственные источники опасаются, что преступник или террорист может использовать ИИ, чтобы помочь в разработке ингредиентов для биологического оружия и отправить их в роботизированную лабораторию, где они могут быть смешаны без какого-либо контроля со стороны человека.

Некоторые полагают, что этот риск вскоре возрастет в геометрической прогрессии, поскольку компании уже тратят сотни миллионов фунтов стерлингов на гораздо более мощные процессоры для обучения следующего поколения программ искусственного интеллекта.

Другой серьезной проблемой является появление «универсального искусственного интеллекта» (AGI), термина, который представляет систему ИИ, способную автономно выполнять любую задачу на человеческом или более высоком уровне и чреватую экзистенциальным риском для людей. Есть опасения, что такая перспектива — вопрос нескольких лет.

Однако подход к экзистенциальному риску AGI также подвергся критике со стороны экспертов по искусственному интеллекту, которые утверждают, что угроза преувеличена, и может быть намеренной дезинформацией ведущих технологических компаний для введения регулирования, исключающего появления новичков в отрасли. На прошлой неделе высокопоставленный технический руководитель заявил американским законодателям, что концепция неконтролируемого AGI является «научной фантастикой».

Тем не менее организаторы на саммите хотят сосредоточить внимание на экзистенциальных рисках, а не на мелочах вроде того, что искусственный интеллект может быть использован для создания дипфейков или привести к дискриминационным результатам, если его использовать для содействия принятия решений в области государственной политики.

Чиновники считают, что лучший способ достичь соглашения между разнообразным кругом стран — это сосредоточиться на негосударственных субъектах, а не пытаться диктовать государствам, как разрабатывать свои собственные технологии.

Британское правительство выделило 100 миллионов фунтов стерлингов на новую целевую группу по искусственному интеллекту, которая поможет тестировать алгоритмы по мере их разработки. Официальные лица планируют использовать саммит, чтобы призвать компании по всему миру отправлять свои ИИ в Великобританию для оценки, прежде чем внедрять их более широко, отмечает газета.